Este año, el Premio Nobel de Física 2024 ha sido otorgado a dos investigadores cuyos trabajos han sentado las bases para el desarrollo de la inteligencia artificial (IA) moderna. John Hopfield, físico de la Universidad de Princeton, y Geoffrey Hinton, científico de la computación de la Universidad de Toronto, fueron galardonados por sus contribuciones pioneras a las redes neuronales artificiales, un componente clave en los avances actuales de la IA. Aunque a simple vista su trabajo puede parecer más cercano a la informática, las raíces de sus investigaciones se encuentran profundamente en los principios de la física, particularmente en la mecánica estadística.

¿Qué son las redes neuronales artificiales y cómo se forman?

Desde los primeros estudios sobre cómo funcionan las neuronas en los cerebros vivos, los investigadores han buscado modelar estas interacciones para crear sistemas computacionales capaces de aprender y procesar información. Las redes neuronales artificiales se inspiran en el funcionamiento del cerebro humano. Están compuestas por capas de “neuronas” interconectadas, las cuales procesan información y la transmiten a la siguiente capa. Usando esta estructura jerárquica entonces se permite que las redes aprendan patrones complejos a través del entrenamiento con grandes conjuntos de datos.

Las redes neuronales artificiales deben su origen a los estudios de neuronas biológicas en cerebros vivos. En 1943, el neurofisiólogo Warren McCulloch y el lógico Walter Pitts propusieron un modelo simple de cómo funciona una neurona . En el modelo McCulloch-Pitts, una neurona está conectada a sus neuronas vecinas y puede recibir señales de ellas. Luego puede combinar esas señales para enviar señales a otras neuronas.

Sin embargo, las neuronas pueden ponderar las señales que vienen de diferentes vecinos de manera diferente. Imagina que estas tratando de decidir que película ver en la visita al cine. Hablas con varios amigos o familia y les preguntas cual ver. Una forma de decidir es juntar los consejos y decidir lo que diga la mayoría. Sin embargo, es posible que confíes más en la opinión de algunas personas, porque saben mas de cine, por lo que podrías decidir darles más peso a sus recomendaciones. Por ejemplo, si un amigo es un gran experto, podrías valer su recomendación tres veces, pero si tienes un amigo en quien desconfías por completo de su opinión, incluso podrías asignarle un peso negativo.

Una vez que hayas tomado tu propia decisión sobre cual es una buena opción, puede ser que otros amigos te hablen para pedirte una recomendación. De manera similar, en las redes neuronales artificiales y biológicas, las neuronas pueden agregar señales de sus vecinas y enviar una señal a otras neuronas. Esta capacidad conduce a una distinción clave: ¿hay un ciclo en la red? Si, como, por ejemplo, si hoy le pregunto a Alicia, Roberto y Carlos, y mañana Alicia me pide una recomendación, entonces hay un ciclo: de Alicia a mí, y de mí de vuelta a Alicia.

En su forma más simple, una red neuronal está compuesta por neuronas conectadas entre sí que reciben señales, las procesan y envían el resultado a otras neuronas. En estas redes, las señales pueden tener diferentes “pesos”, lo que significa que algunas señales tienen mayor importancia que otras, de forma similar a cómo confiamos más en las opiniones de algunos amigos que en las de otros.

Warren McCulloch y Walter Pitts en 1943, imaginaron las neuronas como nodos conectados que reciben señales, las procesan y emiten un resultado. Sin embargo, el verdadero avance llegó cuando John Hopfield introdujo el concepto de redes neuronales recurrentes, un tipo especial de red en la que las conexiones no solo avanzan, sino que pueden retroalimentarse. Este enfoque esta basado en la física estadística lo cual permitió a las redes aprender y memorizar patrones, similar a cómo lo hace nuestro cerebro.

Hopfield, Hinton y las bases de la IA moderna

En mecánica estadística se usa la distribución de Boltzmann , que cuantifica la probabilidad para que se presente un estado determinado. Esta distribución describe la probabilidad de que un sistema este como sólido, líquido o gaseoso, todo en función de su energía y su temperatura. El físico Ernest Ising predijo con exactitud la transición de fase de un imán utilizando la distribución de Boltzmann. Calculó la temperatura a la que el material pasaba de ser magnético a no magnético. En los materiales, los átomos se organizan en estructuras cristalinas específicas que utilizan la menor cantidad de energía. Cuando hace frío, las moléculas de agua se congelan y forman cristales de hielo con estados de energía bajos. En biología, las proteínas se pliegan en formas de baja energía , lo que les permite tener diferentes funciones.

Básicamente, todas las redes neuronales funcionan según un principio similar: minimizar la energía. Las redes neuronales utilizan este principio para resolver problemas informáticos. John Hopfield aplicó principios de la física estadística, como los modelos que se usan para estudiar el magnetismo, para entender cómo las redes neuronales procesan información a lo largo del tiempo. Este trabajo fue fundamental para el desarrollo de redes que no solo pudieran almacenar información, sino también corregir errores, creando una base sólida para la IA. Las redes de Hopfield son capaces de recordar patrones a largo plazo, lo que ha permitido avances en áreas como la corrección automática de errores, entre otras aplicaciones, demostró que su dinámica puede otorgar a dichas redes neuronales una forma de memoria.

Para que las redes neuronales artificiales realicen deberás tareas interesantes, hay que tener un método para asignar la ponderación correcta para las conexiones entre neuronas artificiales. Esto se hace por medio de la retropropagación, este es un algoritmo clave que permite seleccionar pesos en función del rendimiento de la red en un conjunto de datos de entrenamiento. La retropropagación se desarrolló en el campo de la teoría de control y fue aplicada a las redes neuronales por Paul Werbos en 1974. En la década de 1980, Geoffrey E Hinton y sus colaboradores demostraron que la retropropagación puede ayudar a las capas intermedias de una red neuronal a aprender características importantes de la entrada.

Geoffrey E. Hinton, junto con Terrence Sejnowski y otros investigadores, introdujeron las Máquinas de Boltzmann, una clase de redes neuronales que, utilizando principios de la mecánica estadística, no solo almacenan y corrigen patrones, sino que también generan nuevos. Esto dio paso a lo que hoy conocemos como IA generativa, esta es la IA que es capaz de crear texto, imágenes y videos de manera autónoma, como se ha visto en aplicaciones recientes como ChatGPT y otras herramientas de generación de contenido.

Inteligencia Artificial y su impacto en la economía global

El futuro de la generación de datos, de la recolección a la inferencia con IA

La tecnología de inteligencia artificial (IA) está avanzando rápidamente hacia una era en la que los datos recabados ya no serán el único recurso confiable para tomar decisiones. En lugar de depender exclusivamente de datos observables y recogidos del mundo real, los algoritmos de IA, apoyados por la inferencia estadística, están demostrando la capacidad de generar datos inferidos a partir de patrones previamente aprendidos. Este enfoque tiene el potencial de cambiar el paradigma de cómo se generan y utilizan los datos en una variedad de sectores.

¿Qué son los Datos Inferidos?

Los datos inferidos son información que no ha sido directamente observada o recogida, sino que ha sido generada por un modelo basado en patrones estadísticos o matemáticos. Las redes neuronales, como las Máquinas de Boltzmann Profundas, utilizan técnicas de aprendizaje automático para analizar grandes volúmenes de datos y “aprender” cómo se relacionan las diferentes variables entre sí. Una vez entrenadas, estas redes pueden hacer predicciones precisas o completar información que falta basándose en lo que han aprendido.

Por ejemplo, si una IA ha sido entrenada con un conjunto de datos de imágenes de alta resolución de paisajes, puede inferir cómo se verían partes de una imagen que están incompletas o dañadas. Este proceso de inferencia se basa en las relaciones aprendidas entre los píxeles visibles y los ocultos. De manera similar, en un entorno empresarial o de investigación, las IA pueden usar datos incompletos o inconsistentes y, mediante la inferencia estadística, generar nuevos datos que sean consistentes con el conjunto original, ofreciendo predicciones o soluciones.

Datos Recabados vs. Datos Inferidos. Tradicionalmente, las decisiones en casi todos los campos (desde la medicina hasta las finanzas) se han basado en datos recabados: observaciones directas del mundo real. Sin embargo, este enfoque tiene sus limitaciones. La recopilación de datos puede ser costosa, lenta, e incluso imposible en algunos casos. Además, los conjuntos de datos pueden estar incompletos o contener errores.

La inferencia estadística a través de IA ofrece una solución innovadora. En lugar de esperar a que los datos faltantes sean recolectados manualmente, las IA pueden generar datos inferidos con una precisión sorprendente. Esto no significa que los datos observados dejarán de ser relevantes, sino que los datos inferidos pueden complementarlos o incluso reemplazarlos cuando sea necesario. Este enfoque es particularmente útil en situaciones en las que los datos son escasos, difíciles de obtener o donde se necesita una respuesta rápida cuando esa respuesta es lenta por naturaleza.

La IA no solo ha revolucionado sectores tecnológicos, sino que está transformando la manera en que interactuamos con el mundo. En el ámbito empresarial, Google ha sido pionero en el uso de la IA, destacándose por su reciente éxito con el modelo AlphaFold, que utiliza redes neuronales para predecir cómo las proteínas se pliegan, lo cual tiene un enorme potencial para la medicina, el medio ambiente, el reciclaje, la biotecnología, resumiendo esta tecnología de proteínas tiene enormes aplicaciones. Este avance, liderado por Demis Hassabis y John Jumper, fue reconocido con el Premio Nobel de Química 2024, y ese avance se pudo hacer gracias a la IA.

Sin embargo, la relación entre la investigación pura y las aplicaciones empresariales ha cambiado. Según los propios investigadores de Google, la presión por competir en el mercado de la IA ha alterado la cultura de la investigación. Ahora, con el modelo Gemini de Google DeepMind, los investigadores se encuentran en una carrera por desarrollar aplicaciones comerciales basadas en IA. A pesar de las preocupaciones de que la investigación científica pudiera verse limitada, Demis Hassabis considera que los avances en IA son beneficiosos tanto para los negocios como para la sociedad. Según sus propias palabras, “si podemos revolucionar el descubrimiento de medicamentos, será enormemente valioso tanto comercial como socialmente”.

El Futuro de la IA: Riesgos y Oportunidades

El desarrollo de redes neuronales inteligentes ha llegado a un punto en el que no solo son capaces de procesar grandes volúmenes de información, sino que también pueden aprender y mejorar sus propios algoritmos. A medida que la tecnología evoluciona, la IA está comenzando a impactar áreas que van desde la medicina y la biotecnología hasta el clima y la producción industrial. La capacidad de estas redes para aprender patrones complejos está revolucionando industrias enteras, lo que plantea preguntas importantes sobre el futuro de la economía global y el “orden mundial establecido”.

La IA y el Nuevo Orden Mundial

El Premio Nobel de Física 2024 no solo celebra los logros científicos de John Hopfield y Geoffrey Hinton, sino que también nos recuerda cómo las ideas fundamentales de la física han sentado las bases para una de las transformaciones tecnológicas más importantes de nuestra era. La inteligencia artificial está rediseñando el mundo, está transformando industrias y sociedades, desde la forma en que trabajamos hasta cómo interactuamos con la información. A medida que estas tecnologías avanzan, la línea entre lo que es posible para las máquinas y lo que antes solo los humanos podían hacer se está difuminando.

En fimun.com, continuaremos explorando cómo estas innovaciones afectan a la economía global y a la estructura del poder a nivel mundial. La IA no es solo una herramienta tecnológica; es un motor de cambio que está redefiniendo el futuro de nuestra sociedad.

Webgrafía

https://link.springer.com/article/10.1007/BF02478259

https://www.pnas.org/doi/abs/10.1073/pnas.79.8.2554

https://clark.physics.illinois.edu/498cmp/secure/3-Brain/html/1-Hopfield.html

https://www.geeksforgeeks.org/backpropagation-in-neural-network/

https://www.researchgate.net/publication/279233597_Beyond_Regression_New_Tools_for_Prediction_and_Analysis_in_the_Behavioral_Science_Thesis_Ph_D_Appl_Math_Harvard_University

https://www.nature.com/articles/323533a0

https://theconversation.com/nobel-prize-in-physics-spotlights-key-breakthroughs-in-ai-revolution-making-machines-that-learn-240845

https://direct.mit.edu/neco/article-abstract/18/7/1527/7065/A-Fast-Learning-Algorithm-for-Deep-Belief-Nets?redirectedFrom=fulltext

https://public.websites.umich.edu/%7Esidsriva/assets/pdf/talks/WCCM2020_BM.pdf

https://www.bloomberg.com/news/newsletters/2024-10-11/google-s-nobel-haul-puts-spotlight-on-changing-focus-of-scientific-research?srnd=homepage-americas

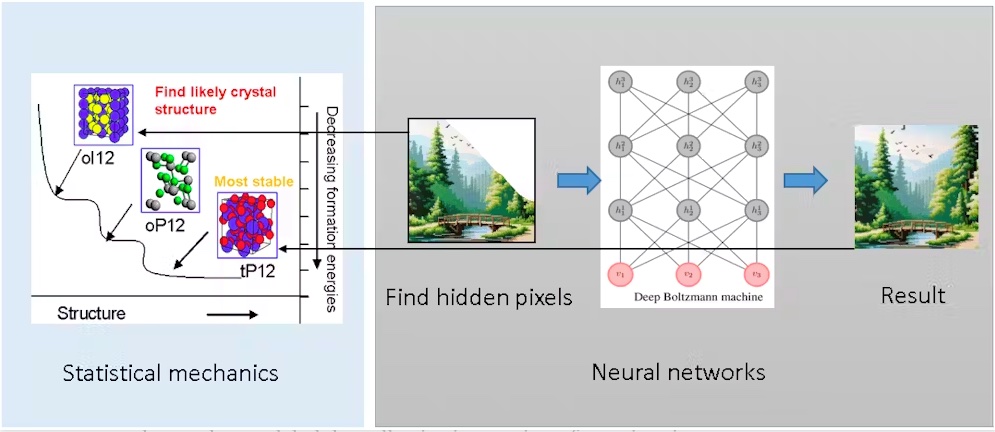

La imagen ilustra cómo se conectan la mecánica estadística y las redes neuronales artificiales para resolver problemas complejos, como la predicción de datos ocultos o incompletos.

Parte Izquierda: Mecánica Estadística

En la parte izquierda de la imagen, se muestra un proceso típico de la mecánica estadística, utilizado comúnmente en la ciencia de materiales. Aquí, la mecánica estadística se aplica para encontrar la estructura cristalina más estable, pasando por diferentes configuraciones como oP12 y tP12. A medida que la energía de formación disminuye, se encuentra la estructura más estable, representada por los cambios de una estructura cristalina menos estable a una más estable. Esto es clave para comprender cómo los sistemas físicos buscan su estado de menor energía, algo que también se refleja en las redes neuronales.

Parte Derecha: Redes Neuronales

La parte derecha de la imagen se enfoca en el funcionamiento de las redes neuronales, específicamente las Máquinas de Boltzmann Profundas. La red neural toma datos incompletos o “píxeles ocultos”, como una imagen parcial, y a través de su procesamiento por capas de neuronas, reconstruye la imagen completa o el “resultado”. En este caso, la red neural no solo almacena patrones, sino que también es capaz de generar datos que faltan, aprendiendo de las relaciones entre las entradas y salidas a través de complejas conexiones internas.

El uso de redes neuronales para predecir datos ocultos se basa en los principios de la mecánica estadística. Al igual que los materiales tienden a alcanzar un estado de baja energía, las redes neuronales buscan configuraciones de menor “energía” o error para producir una salida más precisa y coherente, completando la información que falta.

Conexión entre Mecánica Estadística y Redes Neuronales

La conexión clave entre ambas partes de la imagen es cómo las ideas de la física, como la optimización de energía en sistemas complejos, han sido aplicadas al campo de la inteligencia artificial para construir redes neuronales más eficientes. Las Máquinas de Boltzmann Profundas, nombradas así por el físico Ludwig Boltzmann, utilizan estos principios para calcular probabilidades y predecir configuraciones óptimas, tal como sucede en el estudio de estructuras cristalinas en física.